DAW(音楽制作ソフト)を使ってボーカルレコーディングをしたり、ソフトシンセをリアルタイムで弾く時に気になるのが音の遅れ。レイテンシーと呼ばれるこの音の遅れを解消する、2つの基本的な方法を紹介します。

解決策1. バッファサイズを調整する

DAWには、ほぼ必ずバッファサイズを設定する項目があります。これは音の遅れに最も大きく関わる設定です(※PC内蔵のサウンド機能ではなく、音楽制作用に設計されたオーディオインターフェイスを使用することが前提となります)。

バッファサイズとは何か

バッファ(buffer)とはコンピューター用語で、データを一時的に貯めておく領域を意味します。この領域があることによって、コンピューターにデータを読み込む余裕を与え、途切れることなく再生することができるわけです。

取って出しではなく、ちゃんと在庫を確保してから出荷する感じですかね。例え下手ですね(笑

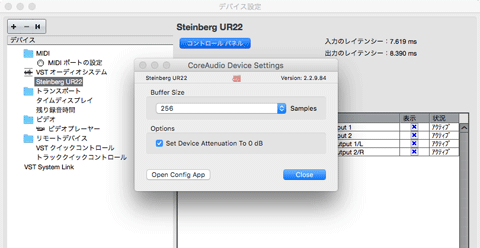

Cubaseのバッファサイズのセッティング画面

バッファサイズが大きければ大きいほど、たくさんのデータを貯めておくことができるようになり、安定した処理ができるようになるわけですが、ここで問題になるのが最初に述べたレイテンシー(音の遅れ、遅延)です。

例えば、DAWのトラックにインサートしたソフトシンセをMIDIキーボードで弾こうと思った時に、バッファサイズが大きすぎると、データを貯めている分、鍵盤を押してから実際にその音が出るまでにタイムラグが生じることになります。もちろん何秒も遅れるわけではないのですが、この微妙なズレというのは演奏する際においてかなりの違和感になります。

では、バッファサイズを常に最小にすればいいかというと、そう簡単な話でもなく、バッファサイズを小さくしすぎると音が途切れたり、プチッというノイズがのったりすることがあるのです。

基本的にバッファサイズはPCの性能が高ければ、小さくしても問題なくデータを処理できるのですが、PCとオーディオインターフェイスの相性なども関係しており、一概にこのくらいのPCの性能ならバッファサイズはここまで詰められる、というようなことはいえません。

というわけで、まずはデフォルトの値(おそらく256か512サンプル)で試してみて、演奏時の遅れが気になるようでしたら、少しずつ値を小さくして最適なところを探っていくのがいいと思います。

バッファサイズを小さくする時は、DAWに表示されているCPU負荷メーターを確認し、限界を超えないように注意しましょう。

サンプリングレートとの関係

実際のレイテンシー(遅延時間)は、バッファサイズだけでなくサンプリングレートとの兼ね合いでも決まります。

基本的な仕組みとして、サンプリングレートが高い(高音質な設定)ほど、同じバッファサイズでもレイテンシーは短くなります。例えば、同じバッファサイズで96kHzと48kHzを比べた時、96kHzのレイテンシーは48kHzの半分です。

「じゃあサンプリングレートを上げれば解決?」と思うかもしれませんが、サンプリングレートを上げるとPCが処理すべきデータ量が爆発的に増え、CPUへの負荷が非常に高くなります。その結果、ノイズが発生しやすくなるため、結局はバッファサイズを大きくして負荷を調整せざるを得なくなることが多いのです。

というわけで、最初は難しく考えず、多くの制作環境で標準的な44.1kHzか48kHzに設定し、まずはバッファサイズの調整だけでレイテンシー対策を行うのがオススメです。

作業によってバッファサイズを使い分けよう

レイテンシー対策としてよく行われるのが、作業内容によってバッファサイズを切り替えることです。

リアルタイム演奏・録音時

→ バッファサイズを小さくする(例: 64, 128, 256 samples)

レイテンシーを最小限に抑え、違和感なく演奏・歌唱するためです。PCへの負荷は高くなります。

ミックス・マスタリング時

→ バッファサイズを大きくする(例: 512, 1024〜 samples)

たくさんのプラグインを使ってもPCが不安定にならないようにするためです。打ち込んだ音やオーディオデータをDAWで再生するだけなら、たとえ何秒遅れようとすべての音が同じ時間遅れるだけで、音のタイミングがズレたりするわけではないので、バッファサイズを気にする必要はありません。

このように、演奏や録音の時は小さく、再生や編集だけの時は大きく、と覚えるだけで、制作効率は格段に上がります。

主要音楽ソフトのバッファサイズ設定方法

STEINBERG Cubase

「スタジオ」→「スタジオ設定」→「(使用しているオーディオインターフェイスの名前)」→「コントロールパネル」

※Cubase 9より前のバージョンでは「スタジオ」ではなく「デバイス」

APPLE Logic

「Logic Pro X」→「環境設定」→「オーディオ」→「デバイス」

ABLETON Live

「オプション」→「環境設定」

IMAGE LINE FL Studio

左上のメニューから「OPTIONS」→「Audio settings」

PRESONUS Studio One

Windows: 上部メニューから「Studio One」→「オプション」→「オーディオ設定」→「オーディオデバイス」→「コントロールパネル」

Mac: 上部メニューから「Studio One」→「環境設定」→「オーディオ設定」→「オーディオデバイス」→「デバイスブロックサイズ」

Audacity

「Audacity」→「設定」→「デバイス」

解決策2. ダイレクトモニタリングを使う

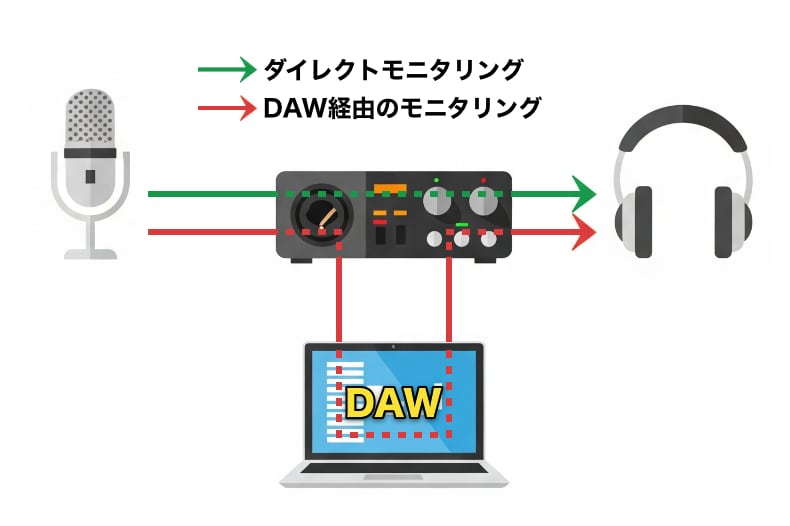

オーディオインターフェイスにつないだマイクや楽器から入力された音声信号は、一度PCのDAW(音楽制作ソフト)を経由し、再びオーディオインターフェイスに戻ってヘッドホンやスピーカーから出力されます。

こうした経路をたどることによって、ヘッドホンやスピーカーに返ってくる音にはレイテンシーが発生します。つまり自分の声や、演奏した楽器の音が遅れて聞こえるということです。

この問題を解消するのが、ダイレクトモニタリング機能です。

ダイレクトモニタリングとは、マイクや楽器から入力された音声信号を、そのままヘッドホンやスピーカーなどの出力に返す機能のことです(※PC側にも音声信号は送られます)。

ダイレクトモニタリングの図

多くのオーディオインターフェイスには、ダイレクトモニタリングをコントロールするスイッチやツマミが付いています。録音時の音の遅れが気になる場合は、このスイッチをオンにしましょう。

ちなみに、オーディオインターフェイスに搭載されているダイレクトモニタリングには、オンオフのみのシンプルなスイッチタイプと、DAWからの出力をミックスすることができるツマミタイプがあります。

STEINBERG UR22の「MIX」ツマミ

左のINPUTに回せばダイレクトモニタリングされた入力音が大きくなり、右のDAWに回せばDAW側の音(伴奏やクリック音等)がミックスされます。

仕組み上、DAWからの再生音にはレイテンシーが発生しているわけですが、DAWがその遅延を自動的に計算し、録音する音のタイミングを補正してくれるので問題ありません。

ダイレクトモニタリングの注意点

ダイレクトモニタリングを使う際は、DAW側の録音トラックのモニタリング(ソフトウェアモニター)をオフ、またはミュートにする必要があります。

DAW経由の音は少し遅れて再生されるため、レイテンシーによる二重音が生じるからです。

また、ダイレクトモニタリングを使うと、ヘッドホンやスピーカーに返ってくる音に、DAW上でかけたエフェクトは反映されません。つまり、PCに届く前の素の音が流れてくるということです。

もし、モニタリングする音にリバーブなどのエフェクトをかけたい場合は、DSP搭載のオーディオインターフェイスを使う方法があります。オーディオインターフェイス内部で処理できるエフェクトを使うことで、PC側にまったく負荷を与えずにエフェクトをかけることができます。

ASIOダイレクトモニタリング

ダイレクトモニタリングは、オーディオインターフェイス本体のスイッチで操作する方法の他に、DAWの画面上からコントロールできる場合もあります。

Windowsでは、ASIOという規格に対応したオーディオインターフェイスとDAWの組み合わせで、DAW上からこの機能を制御できます(ASIOダイレクトモニタリングと呼ばれます)。Macの場合はCore Audioという優れた仕組みがOSに組み込まれており、同様の機能が利用可能です。

DAW上でオン・オフができるので、使い方によっては便利なのですが、今どきのオーディオインターフェイスは、安いものでもたいていダイレクトモニタリング機能を搭載しています。個人でボーカルやギターを遅延なくモニタリングしたいという場合は、本体の機能を使うほうが手軽でわかりやすいかと思います。